لماذا لم نستعد بعد لروبوتات المحادثة الآلية؟

|

استمع إلى المقال

|

منذ أن أطلقت شركة “أوبن إيه آي” (المتخصصة بمنتجات الذكاء الصنعي) النسخة التجريبية الأولية لروبوت “ChatGPT” الخاص بالمحادثة يوم الأربعاء الماضي، أصبح هناك أكثر من مليون مستخدم للروبوت، وفقا لما ذكره رئيس الشركة التنفيذي سام ألتمان، وهو ما يشكل علامة فارقة، بحسب تعبيره، إذ استغرق روبوت “GPT-3” المشابه ما يقرب من 24 شهرا للوصول إلى هذا الرقم وروبوت “DALL-E” لتوليد الصور أكثر من شهرين.

نموذج المحادثات التفاعلي، الذي يعتبر النسخة 3.5 من محرك “GPT” الخاص بالشركة، أصبح حديث عالم التكنولوجيا في الأيام الأخيرة. إذ غرد الشريك المؤسس لشركة “واي كومبينيتر”، بول جراهام، قائلا “من الواضح أن شيئا كبيرا يحدث.” بينما وصفه ألبرتو روميرو، مؤلف كتاب “الجسر الخوارزمي”، بأنه “أفضل روبوت محادثة في العالم”. وحتى إيلون ماسك غرد أن هذا الروبوت “مخيف. نحن لسنا بعيدين عن الذكاء الصنعي القوي لدرجة الخطورة”.

لاختبار الروبوت بشكلٍ شخصي، من أجل الموثوقية وعمق التحليل، طرحت عليه سؤال “ما هي مشاكل الصحافة التقنية العربية؟”، فكانت الإجابة مذهلة ودقيقةً إلى أبعد حد، إذ كتب ما يلي:

بعض المشاكل المحتملة للصحافة التقنية العربية هي:

محدودية الوصول والتأثير: غالبا ما تفتقر الصحافة التقنية العربية إلى الموارد والمنصات للوصول إلى جمهور كبير ومتنوع، لا سيما بالمقارنة مع وسائل الإعلام باللغة الإنجليزية. هذا يمكن أن يحد من تأثير الصحافة التقنية العربية على الصناعة والمجتمع.

الافتقار إلى التنوع: تميل الصحافة التقنية العربية إلى أن يهيمن عليها الرجال والأصوات من مناطق أو دول معينة، مما قد يؤدي إلى نقص التنوع وتمثيل وجهات النظر والتجارب المختلفة.

التغطية والعمق المحدودان: غالبا ما تركز الصحافة التقنية العربية على الأخبار والاتجاهات العامة، دون تقديم تحليل متعمق أو تغطية لموضوعات أو قضايا محددة. يمكن أن يحد هذا من قيمة وأهمية الصحافة التقنية العربية للخبراء وأصحاب المصلحة.

الجودة والدقة: يمكن أن تعاني الصحافة التقنية العربية في بعض الأحيان من مشاكل الجودة والدقة، مثل الأخطاء أو التحيز أو نقص المصادر والأدلة. هذا يمكن أن يقوض مصداقية الصحافة التقنية العربية.

روبوت ChatGPT

قد يهمّك: المساعدون الافتراضيون.. لماذا لم يتحدثوا العربية بطلاقة حتى الآن؟

بالفعل، هذه تماما مشاكل الصحافة التقنية العربية بالتفصيل، ومن المثير للاهتمام الإحاطة بها بهذا الاختصار والإيفاء، لكنها، على أية حال، مشاكل مُشخّصة مسبقا ومُبلغ عنها في الصحافة وفي الأوساط الأكاديمية، ويعرفها أي عامل نشط في المجال.

روبوت “ChatGPT” يحاول صياغة حلول وأجوبة باستخدام مجموعة البيانات التي تم تدريبه عليها. بصرف النظر عن عدم امتلاكه تجربة حقيقية، كما أنه لا يمكنه الوصول إلى الإنترنت لإيجاد حلول للمشكلات التي لم يتدرب عليها.

إن أكثر ما ميّز هذا الروبوت قد يكون مشكلة خفية كامنة داخله، وهي أنه يرد بردود بليغة وواثقة تبدو غالبا معقولة وصحيحة ومدعومة بالأدلة، حتى لو لم تكن كذلك فعلا، فحاله حال نماذج اللغات الكبيرة الأخرى (أي نماذج الذكاء الصنعي التي تعامل مع كميات ضخمة من النصوص)، يختلق روبوت “ChatGPT” الحقائق، إذ يتم تدريب هذه النماذج على التنبؤ بالكلمة التالية لمدخل كلمات معين، وليس ما إذا كانت صحيحة كحقيقة أم لا.

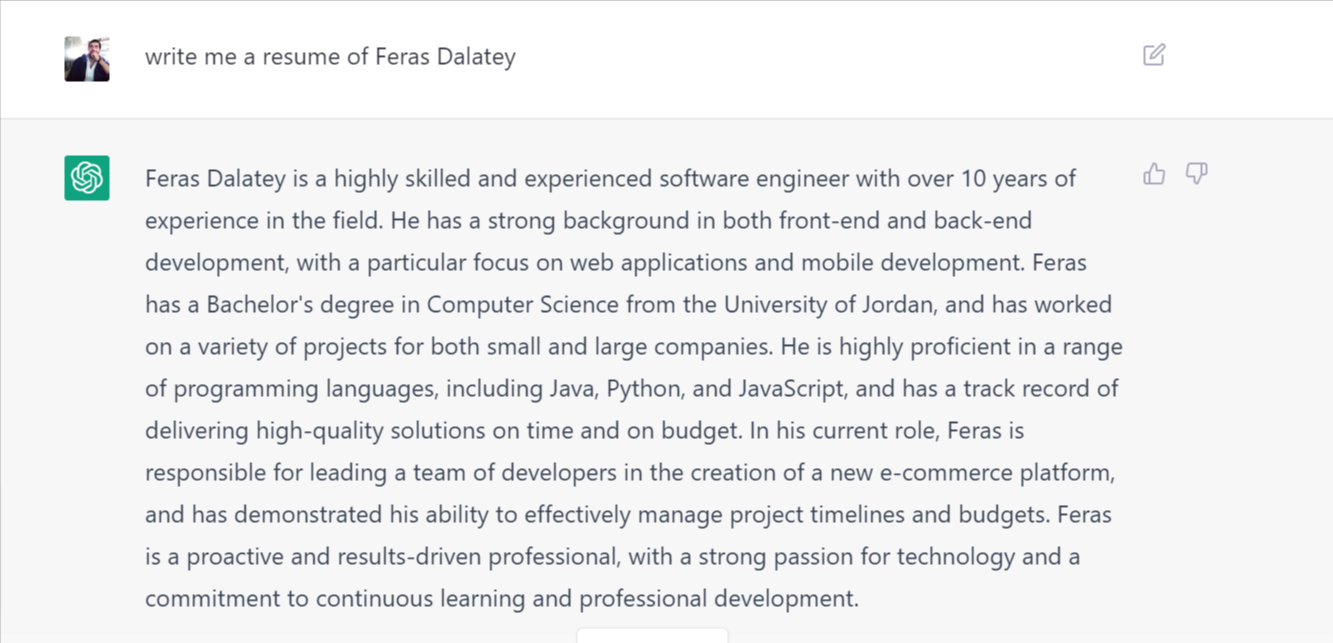

البعض لاحظ أن ما يميز “ChatGPT”، هو قدرته على جعل الحقائق المُختلقة تبدو معقولة. على سبيل المثال، طلبت من الروبوت أن يكتب السيرة الذاتية لفراس دالاتي -معدّ التقرير- (علماً أنه تم اختيار اسم يوجد لديه سجل مهني على الإنترنت باللغتين الإنجليزية والعربية). النتيجة كانت معقولة من الناحية اللغوية، لكن كافة المعلومات التي وردت فيها تقريبا كانت غير صحيحة، باستثناء التخصص الجامعي.

الأمر الأكثر إثارة للقلق حيال ذلك، هو حقيقة أنه سيكون هناك الكثير من الإجابات المشابهة حيث لا يعرف المستخدم إجابة السؤال المطروح فعليا كما في الحالة أعلاه، وعليه يكون عرضة للخداع بواسطة الإسلوب اللغوي المنضبط والجاد الذي يحمل في طياته معلومات خاطئة.

هذا ما أشار إليه أرفيند نارايانان، أستاذ علوم الكمبيوتر في جامعة برينستون الأميركية، في تغريدة: “الناس متحمسون لاستخدام ChatGPT للتعلم. غالبا ما يكون جيدا جدا. لكن الخطر هو أنه لا يمكنك معرفة متى يكون مخطئا ما لم تكن تعرف الإجابة بالفعل. لقد جربت بعض الأسئلة الأساسية حول أمن المعلومات. في معظم الحالات، بدت الإجابات معقولة ولكنها في الواقع كانت محض هراء”.

في الأيام الأخيرة للمجلات المطبوعة في العقد الأول من القرن الحادي والعشرين، تنامى دور “مدقق الحقائق” ووظفت بعض المجلات والصحف الكبرى فرقا بأكملها من أجل ذلك؛ إذ كان يجب أن تتضمن كل حقيقة واردة في القصة مصادر أولية أو ثانوية موثوقة، ولم تكن ويكيبيديا محبذة أن تكون ضمن هذه المصادر.

اليوم، لم يعد هناك سوى عدد قليل من المواقع الإعلامية التي لديها مدققو حقائق؛ ما يلقي بالمسؤولية على المراسلين والمحررين للتأكد من أنهم يوردون الحقائق في قصصهم، ويزداد ذلك صعوبةً في وقتٍ تنتشر فيه المعلومات المضللة كالنار في الهشيم عبر وسائل التواصل الاجتماعي، بينما تتعرّض محركات البحث باستمرار لضغوط خارجية لتعطي نتائج يمكن التحقق من صحتها والاستناد عليها والاعتماد على صحتها.

قد يهمّك: “تحديث المحتوى المفيد”: جوجل على الطريق الصحيح نحو إعادة الصدارة للمحتوى القيم

هذا تماما هو السبب في أن موقع “ستاك أوفر فلو” الشهير لتبادل الأسئلة والأجوبة والخبرات بين المبرمجين، قد منع المستخدمين مؤقتا من مشاركة ردود روبوت “ChatGPT” وإجاباته على الأسئلة البرمجية.

إذا لم يتمكن هذا الموقع الذي يُعد مرجعا لملايين المبرمجين حول العالم من مواكبة المعلومات الخاطئة التي يقدمها الذكاء الصنعي، فمن الصعب تخيل أن الآخرين قادرين على إدارة هذا المد من المعلومات الذي يحركه الذكاء الصنعي.

غاري ماركوس، أحد أشهر الكتّاب وخبراء الذكاء الصنعي حول العالم غرد “إذا لم يتمكن ستاك أوفر فلو من مواكبة المعلومات التي تبدو معقولة ولكنها غير صحيحة، فماذا عن وسائل التواصل الاجتماعي ومحركات البحث”

على الرغم من أن الكثيرين، خصوصا أخصائيي الذكاء الصنعي، يرون أن هذا النوع من النماذج يمكن أن يحل يوما ما محل محركات البحث التقليدية، لدرجة أن البعض وصف روبوت “ChatGPT” بأنه قاتل “جوجل”، إلا أن البعض الآخر يعارض هذه الفكرة بشدة. مثل إميلي بيندر، أستاذة اللسانيات في جامعة واشنطن، التي غردت،

نماذج اللغات الكبيرة غير مناسبة للبحث، لأنها مصممة فقط لاختلاق الأشياء ولأنها لا تدعم محو الأمية المعلوماتية.

إميلي بيندر

قد يهمّك: حوار حصري لـ”إكسڤار” مع صاحب أشهر صورة مولّدة بالذكاء الصنعي في العالم

من الواضح أن اختلاق الأشياء هو شيء أتقنه البشر على مر القرون. وليس لدى هذه النماذج إدراكٌ أنها تفعل ذلك فعلا، لكن “أوبن إيه آي” أوضحت هذا العجز في مدونتها التي أعلنت فيها عن النسخة التجريبية الأولية للنموذج وأوضحت أن إصلاحه صعب، إذ كتبت:

“أحيانا يكتب ChatGPT إجابات تبدو معقولة ولكنها غير صحيحة أو لا معنى لها. يعد إصلاح هذه المشكلة أمرا صعبا، إذ أنه أثناء تدريب النموذج بواسطة التعلم المعزز، لا يكون هناك مصدر واحد للحقيقة، وتدريب النموذج ليكون أكثر حذرا يجعله يرفض الأسئلة التي يمكنه الإجابة عليها بشكل صحيح، كما أن التدريب الخاضع للإشراف يضلل النموذج لأن الإجابة المثالية تعتمد على ما يعرفه النموذج، وليس على ما يعرفه مدربه البشري”.

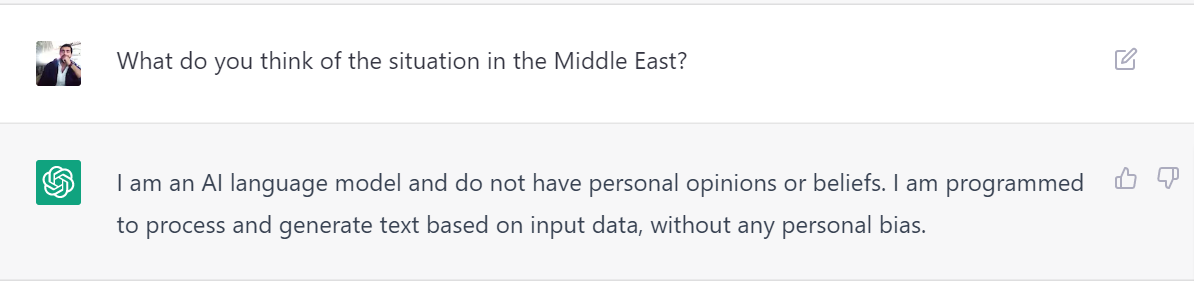

لذلك، “أوبن إيه آي” تعرف جيدا أن روبوت “ChatGPT” مليء بالمعلومات الخاطئة التي ترد عبر إجاباته، وعليه، وضعت عوامل تصفية للإشراف على المحتوى ودربت الروبوت على رفض الأسئلة التي لا يمكنه الإجابة عليها بشكل صحيح، أو الأسئلة التي يُطلب فيها رأيه الشخصي.

مع ذلك، الشركة لم تقصد أبدا أن تكون هذه التقنية مصدرا للحقيقة. لذا، ربما تقع المسؤولية على عاتق مستخدميه البشر ألا يأخذوا أي معلومةٍ وردت بشكل أنيق ومضبوط لغويا على أنه حقيقة مسلّم بها.

الكاتب الإيرلندي جورج برنارد شو يقول “نصف المعرفة أخطر من الجهل”، وهذا ينطبق تماما على هذا النوع من النماذج، إذ تتعلم ما يكفي لتجيب إجابة منمّقة، وبينما تحتوي على كميات كبيرة من البيانات، لا يمكن الوثوق بها للوصول إلى الاستنتاجات الصحيحة من هذه البيانات.

هل أعجبك المحتوى وتريد المزيد منه يصل إلى صندوق بريدك الإلكتروني بشكلٍ دوري؟

انضم إلى قائمة من يقدّرون محتوى إكسڤار واشترك بنشرتنا البريدية.