جهود لإيقاف تقنيات “ديب فيك“.. كيف ستنجح؟

|

استمع إلى المقال

|

تقنيات “ديب فيك” تسمح للمستخدمين ببناء مقاطع فيديو ومقاطع صوتية وصور مزيفة بالكامل ولا أساس لها من الصحة، وذلك عبر تسخير الذكاء الاصطناعي لصالح هذه الجهود، ورغم أن مثل هذه التقنيات تمتلك مستقبلا باهرا، إلا أن البعض أساء استخدامها.

الابتزاز الجنسي وطلب الفدية والتعويضات المالية هي إحدى الأوجه التي استخدمت فيها تقنيات “ديب فيك” بشكل كبير، وبسبب المخاوف من توسع رقعة استخدامها، بدأ الباحثون حول العالم في محاولة تطوير طرق جديدة من أجل حماية المستخدمين من هذا الخطر والتعرف على المقاطع المزيفة فور صدورها، فكيف ستنجح هذه الجهود.

التطور الكبير الذي وصلت إليه تقنيات الذكاء الاصطناعي التوليدي سواء عبر نماذج الذكاء الاصطناعي المتاحة للمستخدمين أو حتى تلك المتاحة للشركات فقط، كان سببا رئيسيا وراء تطور تقنيات التزييف العميق وجعلها تقترب من الواقع كثيرا.

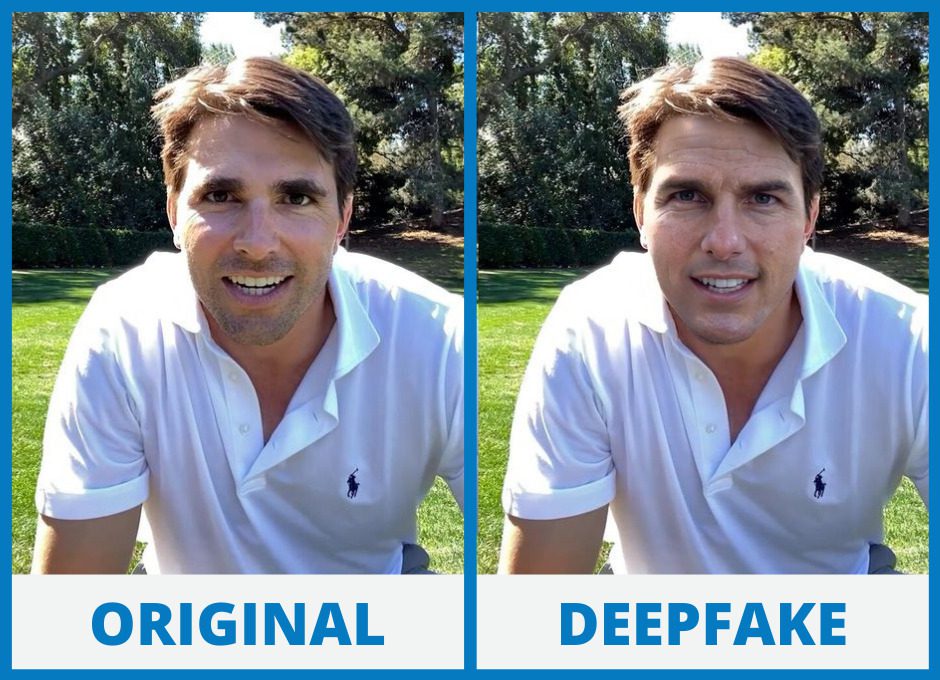

في الماضي، كنت تحتاج إلى فنيّ تزييف يمتلك مهارات خاصة حتى يعالج مقاطع الفيديو والأصوات والصور لتبدو أقرب إلى الواقع، ورغم ذلك، كان يمكن للمحترفين التمييز بين المقاطع المزيّفة وتلك الواقعية، كما أن انتشار هذه المقاطع المزيفة كان أمرا صعبا؛ لأن الإنترنت ومنصات التواصل الاجتماعي لم تكن بهذه القوة والانتشار الواسع.

الآن لا يحتاج الأمر إلا لشخص مدرب على توجيه الأوامر للذكاء الاصطناعي حتى يتمكن من بناء مقاطع فيديو مزيّفة بالكامل في ثوان معدودة. صحيح أنك تحتاج إلى آلاف المقاطع والصور للشخص الذي ترغب في تزييفه، ولكن الوصول إلى هذا ليس صعبا في العصر الحالي.

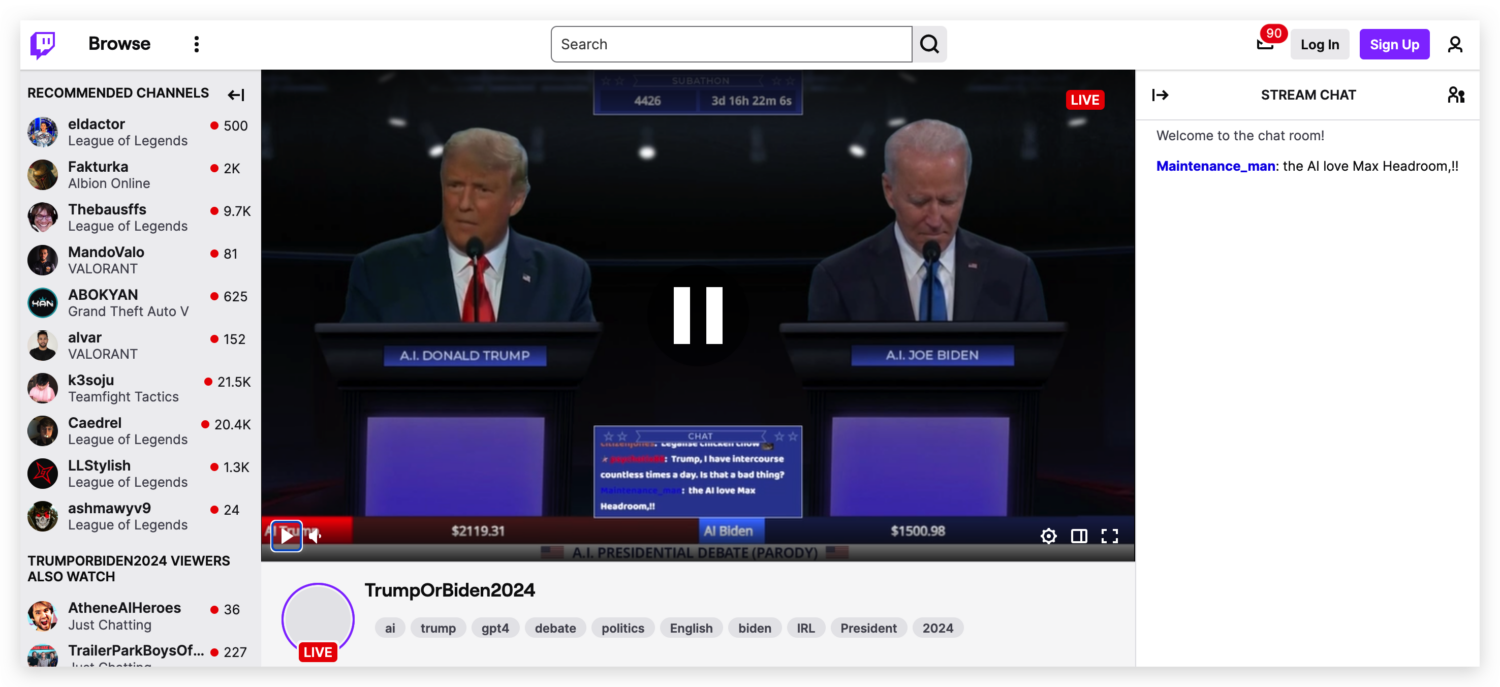

المشاهير ورجال السياسة والمؤثرين هم أكثر ضحايا تقنيات “ديب فيك”، وهناك الكثير من الحالات التي تشهد بذلك، ربما كان أحدثها تزوير مقاطع صوتية مسيئة للمؤثر المصري “جو موسى”، إلى جانب القناة المزيفة في “تيك توك” التي تنشر مقاطع مزيفة لتوم كروز، وهناك أيضا مقاطع كثيرة ومتعددة لشخصيات سياسية عامة مثل جو بايدن ودونالد ترامب مولدة بالكامل بالذكاء الاصطناعي، ومن ضمنها مناظرة استمرت لأيام دون أن يكون لها أي أساس من الصحة.

بالطبع، مخاطر هذه التقنيات تزداد عندما تدخل إلى مجالات السياسة المختلفة، فقد تسبب في أزمات سياسية ضخمة وقد تغير مسار الانتخابات بشكل كامل، لهذا كان يجب أن تتوسع الجهود في محاولة إيقاف مقاطع “ديب فيك” المزيفة.

فريق بحثي في جامعة “MIT” أدرك مخاطر تقنيات التزييف العميق وكمية الأضرار التي يمكن أن تتسبب بها، لذلك قرر أن يبتكر تقنية تدعى “PhotoGuard”، وهي تقنية تعمل على وضع بصمة مائية غير مرئية للعين المجردة، ولكنها قابلة للالتقاط من قبل أجهزة الحاسوب المعتادة مهما كانت قوتها، وهذه البصمة تشوش قدرة الذكاء الاصطناعي على استخدام الصورة الأصلية ووضعها في مقطع مزيف.

التقنية الجديدة تعمل عبر استخدام نوعين من آليات الحماية، الأولى تدعى “encoder” وهي المسؤولة عن تشويش قدرة الذكاء الاصطناعي لقراءة الصورة، أما الثانية، فهي تدعى “Diffusion”، وهي تعتمد على آليات رياضية معقدة تخبئ صورة مغايرة فوق الصورة الأصلية، ولنطلق على طبقة الصورة العلوية اسم صورة الحماية.

عندما يحاول الذكاء الاصطناعي تعديل الصورة الأصلية، فإنه يتعرف أولا على صورة الحماية ويظن بأنها الصورة الحقيقية والوحيدة، لذلك يقوم بتعديلها دون النظر إلى الصورة الأصلية، وهنا تبدو النتيجة غير منطقية وغير واقعية للغاية، وهذا ما يضمن تميز الصور المزيفة بسهولة للعين غير المدربة.

هذه التقنية تعد بمستقبل واعد في مكافحة صور “ديب فيك” ومحاولة إيقافها، ولكن قد لا يكون هذا كافيا لإيقاف التقنية بشكل كامل؛ لأنها في النهاية تعتمد على تطبيق آلية الحماية فوق الصورة الأصلية، لذلك إن لم تقم بتطبيق الحماية فوق الصورة الأصلية، فإن صورك ستكون عرضة لهذه التقنيات.

بعض الشركات التقنية بدأت في تقديم خدمات اكتشاف الصور والمقاطع المزيفة، ولكن هذا على نطاق ضيق وعلى شكل خدمات مدفوعة تقدمها لمن يرغب بها، لذلك فهي تعمل بعيدا عن منع التقنية أو مكافحتها بشكل كامل.

شركة “إنتل” الرائدة في تصميم شرائح الحاسوب والمعالجات قدمت نسخة خاصة من تطبيق يدعى “Real-Time Deepfake Detector“، وهي تعمل على قراءة المقاطع والصور واكتشاف إن كانت مزيفة أم لا، وتصل درجة دقتها إلى 96 بالمئة.

هناك تقنيات أخرى تعمل على هذا الأمر أيضا، مثل “WeVerify“، وغيرها من الشركات الأخرى التي تحاول مكافحة هذه الآفة قبل تفشيها ووصولها إلى مستوى لا يمكن السيطرة عليه معها، ولكن كل هذه الجهود دون دعم حكومي ستكون قاصرة وغير قادرة على القضاء على التزييف العميق تماما.

دون أن تطبق الحكومات قوانين وشروط رادعة تمنع الشركات من إتاحة كافة مزايا التزييف العميق بسهولة، فإن جميع الجهود التقنية والبحثية لمنع هذه الآفة ستكون دون طائل.

القوانين الرادعة يجب أن تجبر الشركات على وضع قيود تقوض من قدرة الذكاء الاصطناعي التوليدي على التزييف، ويجب أن تكون القوانين رادعة تمنع هذه التطبيقات بشكل كامل في بعض الحالات والاستخدامات، وذلك من أجل حماية المستخدمين من مخاطرها.

الوعي العالمي بتقنيات الذكاء الاصطناعي آخذ في التزايد بشكل مطرد، وأصبحنا نرى هيئات حكومية وقمم دولية تبحث في أمور الذكاء الاصطناعي وقوانينه، لذلك لن يكون بعيدًا أن نرى قوانين جديدة رادعة لآليات التزييف العميق وتزوير المقاطع عبر “ديب فيك”.

هل أعجبك المحتوى وتريد المزيد منه يصل إلى صندوق بريدك الإلكتروني بشكلٍ دوري؟

انضم إلى قائمة من يقدّرون محتوى إكسڤار واشترك بنشرتنا البريدية.