الوجه القبيح للذكاء الاصطناعي.. صور إساءة الأطفال المزورة تغزو الإنترنت

|

استمع إلى المقال

|

هل تعلم أن هناك ملايين الصور المزورة لإساءة الأطفال الجنسية على الإنترنت، وهل تتخيل كيف يشعر طفل حقيقي عندما يرى صورته المزورة، وهو يتعرض للإساءة، وهل تظن أن الذكاء الاصطناعي هو صديق أم عدو لحقوق وحماية الأطفال. هذه بعض الأسئلة التي يجب أن نطرحها على أنفسنا عندما نواجه مشكلة صور إساءة الأطفال المزورة، والتي تستخدم تكنولوجيا الذكاء الاصطناعي لإنشائها، هذه المشكلة هي سرطان ينخر في جسد المجتمع، ويهدد حياة ومستقبل الأطفال، إنه سلاح ذو حدين، يستخدمه المجرمون لإشباع رغباتهم المريضة وإخافة وابتزاز ضحاياهم، إنه نار تحت الرماد، تشتعل بسهولة وتصعب إطفاءها.

في هذا التقرير، سنستعرض كيف يستخدم المجرمون نماذج الذكاء الاصطناعي التوليدية، والتي تتيح للمستخدمين وصف بالكلمات ما يريدون إنتاجه من صور، هدفها الإساءة لحقوق وسلامة الأطفال، وسنشارك بعض الحقائق والأرقام المروعة عن حجم وانتشار هذه الظاهرة، وكيف تؤثر في ضحايا حقيقيين وافتراضيين، سأبحث أيضا في التحديات والحلول المحتملة لمواجهة هذه الجريمة، ودور الحكومات ومزودي التكنولوجيا والمجتمع في حماية الأطفال من هذا الخطر.

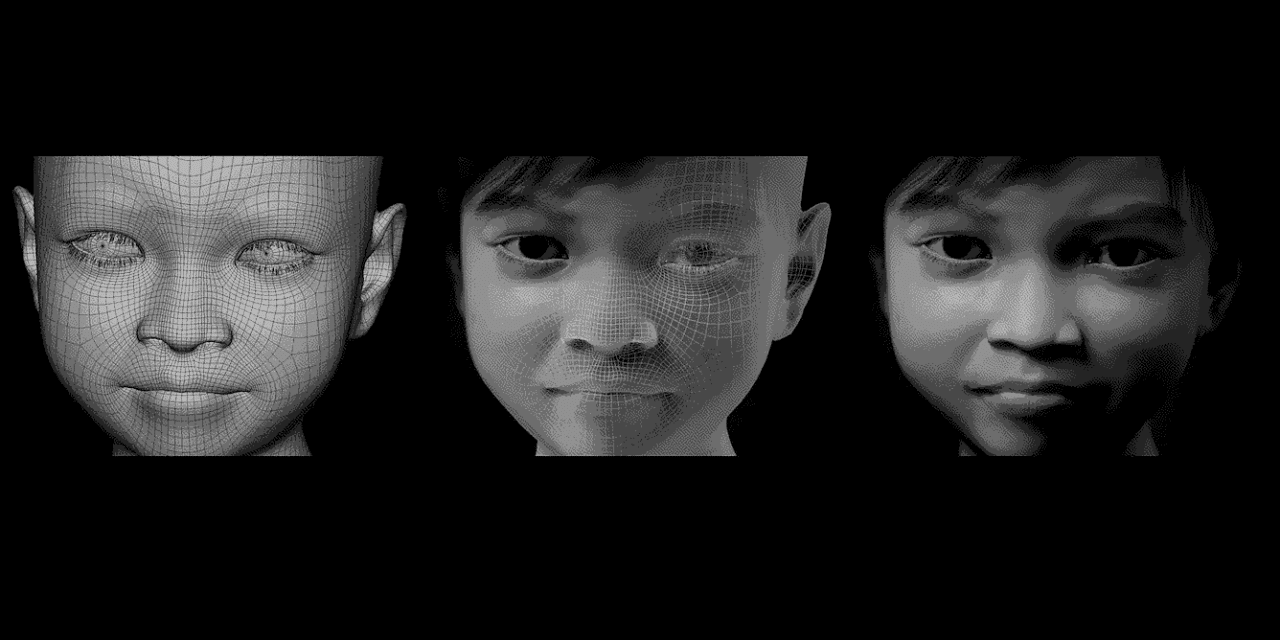

مع زيادة استخدام الذكاء الاصطناعي لإنشاء صور واقعية بشكل لا يصدق، نجد أنفسنا أمام تحديات جديدة ومروعة، إذ يحذر الخبراء من تفشي الصور الإباحية للأطفال، باستخدام نماذج الذكاء الاصطناعي القائمة على المصدر المفتوح، التي تستطيع إنتاج الصور والتي لها آثار مدمرة لا توصف، يتم استخدام هذه التكنولوجيا لإنشاء مئات الصور الجديدة للأطفال الذين تعرضوا للاعتداء، يقوم المجرمون بمشاركة مجموعات بيانات تحتوي على صور سوء المعاملة، وهم يبدأون في بيع اشتراكات شهرية لمحتوى صور الاعتداء الجنسي على الأطفال التي تم إنشاؤها بواسطة الذكاء الاصطناعي.

تفاصيل كيفية سوء استخدام هذه التكنولوجيا وردت في تقرير جديد وشامل صدر عن مؤسسة مراقبة الإنترنت (IWF)، وهي منظمة غير ربحية مقرها المملكة المتحدة تبحث وتزيل المحتوى المسيء من الويب، وذلك في حزيران/ يونيو الماضي، إذ أعلنت مؤسسة مراقبة الإنترنت أنها اكتشفت 7 عناوين URL على الويب المفتوح تحتوي على مواد مشتبه في صنعها بواسطة الذكاء الاصطناعي؛ والآن، كانت تحقيقاتها ضمن منتديات الإنترنت المظلم تتعلق بمواد الاعتداء الجنسي على الأطفال، وتقدم لنا نظرة عن كيفية استخدام الذكاء الاصطناعي، وقد اكتشفت المؤسسة تقريبا 3 آلاف صورة تم إنشاؤها بواسطة الذكاء الاصطناعي وتعتبرها غير قانونية وفقا للقانون البريطاني.

تتضمن الصور التي تم إنشاؤها بواسطة الذكاء الاصطناعي اغتصاب الرضع والأطفال الصغار، بالإضافة إلى المحتوى الجنسي الذي يتضمن المراهقين في ممارسة ألعاب الجنس القاسية، وفقا لأبحاث مؤسسة مراقبة الإنترنت، ويقول دان سيكستون، مدير التكنولوجيا الرئيسي في المؤسسة، “لقد رأينا طلبات ومناقشات وأمثلة فعلية لمواد الاعتداء الجنسي على الأطفال تتضمن المشاهير”، وفي بعض الحالات، تم تصغير المشاهير لتبدو وكأنهم أطفال، وفي حالات أخرى، يتم تصوير المشاهير البالغين، وهم يرتكبون أفعال الاعتداء على الأطفال.

بينما تبقى تقارير الصور الإباحية التي تم إنشاؤها بواسطة الذكاء الاصطناعي محدودة بالمقارنة مع عدد الصور والفيديوهات الفعلية للإساءة الموجودة على الإنترنت، فإن سيكستون يعرب عن قلقه إزاء سرعة التطور والإمكانات التي يخلقها ذلك لأنواع جديدة من الصور السيئة، وتتوافق هذه النتائج مع نتائج مجموعات أخرى تحقق في انتشار مواد الاعتداء الجنسي على الأطفال عبر الإنترنت، وفي قاعدة بيانات واحدة مشتركة، لقد قام محققون حول العالم بإشارة إلى 13،500 صورة مولدة بواسطة الذكاء الاصطناعي للاعتداء الجنسي على الأطفال واستغلالهم، وفقا لما يقوله لويد ريتشاردسون، المدير التكنولوجي للمركز الكندي لحماية الأطفال، ويضيف ريتشاردسون، “هذا مجرد جزء صغير من الصورة”.

تطورت الأنظمة الحالية المختصة في إنتاج الصور الذكية الاصطناعية بسرعة مذهلة، حيث أصبح بإمكانها إبداع أعمال فنية جذابة وصور واقعية مذهلة وتصاميم فريدة، مما يمهد الطريق لمستوى جديد من الإبداع، ويعد بتغيير الفن إلى الأبد، ومن الجدير بالذكر أن هذه الأنظمة ليست محصورة فقط على الإبداع الفني، بل تم استخدامها أيضا في تزوير الصور بشكل مقنع، مثل بابا الفاتيكان، وهو يرتدي ملابس غريبة وإنتاج صورة من اعتقال الرئيس الأميركي السابق دونالد ترامب.

هذه الأنظمة تخضع لتدريب مكثف على مجموعات ضخمة من الصور الموجودة بالفعل، غالبا ما يتم جمعها من الويب دون إذن مسبق، وهي تتيح إنتاج الصور بناء على تعليمات نصية بسيطة، على سبيل المثال، إذا طُلب منها “رسم فيل يرتدي قبعة”، ستكون قادرة على إنتاج هذه الصورة دون أي مشكلة.

ليس من المفاجئ أن يلجأ المجرمون الذين يخترقون الأخلاق، وينتجون صور اعتداءات جنسية على الأطفال إلى استخدام هذه التقنيات، على حسب تصريح سيكستون، يتوفر عادة البرمجيات اللازمة لإنشاء هذه الصور للجميع، وقد لاحظت الجمعية الدولية للإنترنت (IWF) أن المجرمين الذين نشرت أعمالهم بانتظام يشيرون إلى “Stable Diffusion”، وهو نموذج ذكاء اصطناعي تم توفيره من قبل شركة “Stability AI” في المملكة المتحدة، وواجهت الشركة العديد من الانتقادات، في الإصدار الثاني من النموذج التي تم إصدارها في نهاية العام الماضي، أجرت الشركة تعديلات على نموذجها لجعل إنتاج صور الاعتداء الجنسي على الأطفال والصور العارية أمرا أصعب.

تجدر الإشارة، إلى أن المجرمين يعتمدون على النماذج القديمة للذكاء الاصطناعي ويجرون تعديلات عليها لإنشاء مواد غير قانونية تتعلق بالأطفال، مما يتضمن إدخال صور اعتداءات جنسية موجودة بالفعل أو صور لأشخاص، مما يتيح للذكاء الاصطناعي إنتاج صور لأفراد محددين، وحد تعبير سيكستون، “نجد نماذج معدلة تقوم بإنشاء صور جديدة لضحايا موجودين بالفعل”، حيث يتم مشاركة مئات الصور الجديدة لضحايا محددين وتبادل معلومات عن أفراد معينين، وتشير الأبحاث إلى أن بعض المناقشات في منتديات الشبكة المظلمة تشمل مشاركة مجموعات صور لوجوه الضحايا، وتم تسمية أحد هذه المناقشات بعنوان “مصادر الصور للذكاء الاصطناعي وإنتاج صور مزيفة لفتيات محددات”.

فهم حجم هذه المشكلة يشكل تحديا كبيرا، خلال شهر أيلول/سبتمبر، ركز محللو الجمعية الدولية للإنترنت على أحد منتديات الشبكة المظلمة المتخصصة في صور الاعتداء الجنسي على الأطفال، والذي لم يتم ذكر اسمه، بحسب المؤسسة تم نشر إجمالي 20,254 صورة مولدة بواسطة الذكاء الاصطناعي في قسم جديد من المنتدى خلال الشهر الماضي، وأجرى الباحثون تقييما لـ 11,108 من هذه الصور حيث قضى فريق مكون من 12 محللا تقييما استغرق 87،5 ساعات.

بشكل عام، قامت الجمعية الدولية للإنترنت بتصنيف 2,978 صورة على أنها جريمة، حيث كانت 2,562 صورة منها واقعية بما يكفي لتصنيفها بنفس طريقة الصور التقليدية للاعتداءات الجنسية على الأطفال، وقد تم تصنيف نصف الصور كفئة C، مما يعني أنها غير أخلاقية، بينما تظهر 564 صورة أنواع من الاعتداءات الجنسية الأشد، وتشير الصور على الأرجح إلى أن أعمار الأطفال فيها تتراوح بين 7 و13 عاما، حيث كانت الأطفال الإناث تشكل 99،6 بالمئة من الصور وفقا للجمعية الدولية للإنترنت، وتجدر الإشارة إلى أن معظم هذه الصور الاصطناعية لم تشمل أنشطة جنسية، ولكنها تظهر أطفالا.

نيشانت فيشواميترا، أستاذ مساعد في جامعة تكساس في سان أنطونيو، يشير قائلا إلى أن “المشكلة تكمن في حجم الصور التي يمكن إنشاؤها”، حيث يمكن إنتاج ملايين الصور في دقائق قليلة، وهذا يشكل تحديا كبيرا للمجتمع وجهود الجهات الرقابية لمكافحة الاعتداء الجنسي على الأطفال وحماية الضحايا.

لمواجهة هذه المشكلة المتزايدة، تعمل الجهات الرقابية والاستخباراتية بالتعاون مع الشركات التكنولوجية على تطوير أدوات وتقنيات لاكتشاف ومنع الصور الاصطناعية غير القانونية، تعتمد هذه الجهود على تحليل البيانات واستخدام الذكاء الاصطناعي للكشف عن النمط والمحتوى الذي قد يشير إلى وجود صور غير قانونية؛ ومع ذلك، تبقى هذه المهمة صعبة بسبب التحديات التقنية والكمية الكبيرة من البيانات التي يتعين مراجعتها.

إضافة إلى ذلك، تعمل الحكومات والمنظمات الدولية على تشديد التشريعات والقوانين لمكافحة الاعتداء الجنسي على الأطفال وتجريم إنتاج وتوزيع واستخدام الصور الاصطناعية غير القانونية، يشمل ذلك زيادة العقوبات للمتورطين وتعزيز التعاون الدولي في مجال مكافحة هذه الجرائم.

مع التطور الرهيب للتكنولوجيا الذكية وتزايد استخدامها في تصميم المحتوى الضار، نجد أنفسنا مطالبين باتخاذ خطوات فعّالة لمواجهة هذه التحديات، يتمثل القلق في العديد من الدول حيث يُعتبر إنتاج ونشر المحتوى الاصطناعي الخاص بالأطفال عملا غير قانوني ومخالفا للقوانين الخاصة بحماية الطفل، هذا هو ما تشدد عليه أردا جيركنز، رئيسة هيئة مكافحة المواد الإرهابية والإباحية الخاصة بالأطفال على الإنترنت في هولندا، حيث تُشير إلى أن “حيازة ونشر وعرض وإنشاء هذا المحتوى يعتبر غير قانوني بالفعل”، وقد نادى مدعين عامين في الولايات المتحدة بتشديد القوانين المتعلقة بهذا المحتوى، وأن على الجميع تبنى نهجا متعدد المجالات لمكافحة هذه الآفة على الإنترنت.

هناك طرق وإجراءات متعددة تُدرس حاليا من قبل شركات التكنولوجيا والباحثين لمنع إنتاج المحتوى الاصطناعي الخاص بالأطفال الذي يُنشأ بواسطة الذكاء الاصطناعي وكذلك لمنع انتشاره من المنتديات السرية على الإنترنت، يمكن لشركات التكنولوجيا التي تطور نماذج الذكاء الاصطناعي أن تطبق ضوابط أفضل تضمن وجود ضمانات، وهنا يجب على جميع مطوري التكنولوجيا أن يدركوا إمكانية سوء استخدام أدواتهم، وأن يعملوا على توفير حماية مناسبة.

هذه الضمانات تشمل وضع علامات مائية على الصور، وتطوير أدوات اكتشاف أفضل، والتعرف على الأسباب التي يمكن أن تؤدي إلى إنشاء محتوى غير أخلاقي للأطفال بواسطة الذكاء الاصطناعي، تسعى شركات التكنولوجيا الرائدة إلى استخدام نماذج التعلم الآلي لمساعدتها على كشف المحتوى الإباحي الجديد الذي قد ينشر على منصاتها، بالإضافة إلى استخدام الأدوات الحالية المتاحة.

لكن هذا كله يأتي متأخرا؛ نظرا لاستخدام التكنولوجيا بالفعل لإنشاء محتوى ضار، علينا أن ندرك أن أي شيء تقوم به بعد الحادث لا يمكن أن يعالج الجذور، الجهود الحالية تتركز على تنظيف المحتوى الذي أنشئ بالفعل، ولكن التقنية مستمرة في التطور، ومن المرجح أن تظهر تحديات جديدة في المستقبل، يجب على المجتمع الدولي والصناعة العمل معا لمكافحة هذه التحديات وضمان بيئة آمنة على الإنترنت للأطفال.

هل أعجبك المحتوى وتريد المزيد منه يصل إلى صندوق بريدك الإلكتروني بشكلٍ دوري؟

انضم إلى قائمة من يقدّرون محتوى إكسڤار واشترك بنشرتنا البريدية.